CSIG 3DV专委会 [成果速览] 2021年第3期(总第3期)

1.论文动机

双目立体视觉作为计算机视觉的重要分支,近年来在自动驾驶、SLAM、VR/AR等场景中得到了广泛的应用。双目立体视觉基于视差原理,利用成像设备从不同的位置获取被测物体的左右两幅图像,通过计算图像对应点间的位置偏差,获取物体的三维信息。由于双目图像间的视差较大(通常可达几十甚至上百像元),之前方法多利用cost volume建立长距离对应点之间的关系。但构建cost volume需要场景的最大视差(通常设置为192)作为先验信息,当场景视差范围变化较大时适应能力较差;同时4D cost volume会带来较大的内存开销和计算量。今天向大家介绍一篇国防科技大学等单位发表在TPAMI 2020上的论文,该工作提出了一种用于无监督立体匹配学习的视差注意力机制。考虑到真实世界中密集的视差标记通常获取较为困难,视差注意力机制致力于以无监督的方式学习双目图像间的对应关系;同时该机制摆脱了对先验视差范围的依赖,具有较低的内存开销和计算量,能够更好地适应真实世界中不同深度、分辨率、焦距等应用场景。该工作将视差注意力机制成功应用到双目立体匹配与双目图像超分辨任务上,均取得了很好的性能。

2.论文题目

[IEEE TPAMI 2020] Parallax Attention for Unsupervised Stereo Correspondence Learning

王龙光1, 郭裕兰1, 王应谦1, 梁正发2, 林再平1, 杨俊刚1, 安玮1

(1国防科技大学, 2盲信号处理国家级重点实验室)

论文链接: https://ieeexplore.ieee.org/document/9206116/

代码开源: https://github.com/LongguangWang/PAM

数据开放:https://yingqianwang.github.io/Flickr1024/

3.创新点

(1)提出了一种通用的视差注意力机制,可以不依赖于视差标签,无监督地学习双目图像间的对应关系;

(2)设计了基于视差注意力机制的损失函数,能够减少双目立体匹配中的歧义性,提高匹配准确性;

(3)提出了基于视差注意力机制的双目立体匹配与双目图像超分辨网络,均取得了很好的性能。

(4)提出了首个用于双目图像超分辨的数据集Flickr1024,该数据集包含1024对高质量的双目图像。

4.相关工作

2.1有监督双目立体匹配

传统双目立体匹配方法大多遵循了“匹配代价计算-代价聚合-视差回归-视差细化”的处理流程。早期基于CNN的工作利用CNN完成上述处理流程中的一步或者多步。后来Mayer等人[1]提出了首个端对端的网络(DispNet),通过构造3D cost volume直接回归视差。近期工作[2]主要利用4D cost volume和3D卷积进行视差聚合和回归,取得了比3D cost volume方法更优的性能。

2.2无监督双目立体匹配

由于真实世界中密集的视差标记通常获取较为困难,一些无监督双目立体匹配的工作[3]利用左右目图像间的一致性进行视差估计。遮挡、光照变化、无(弱)纹理等因素是无监督双目立体匹配任务的重要挑战。

2.3双目图像超分辨

双目图像超分辨致力于利用一对低分辨率双目图像重建一张高分辨率左图图像。由于双目图像独有的特性(对极几何关系、视差较大等),已有的多帧图像超分辨方法(视频超分辨、光场超分辨等)都难以直接应用到双目图像超分辨任务中。Jeon等人[4]将右图偏移不同的像元并与左图级联,之后将级联后得到的张量送到送到网络中进行超分辨。

2.4注意力机制

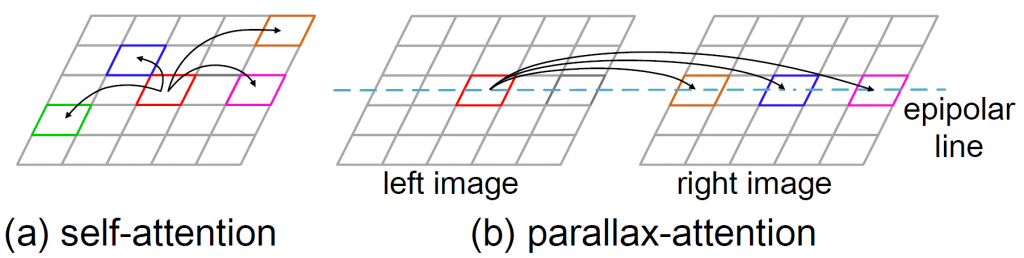

注意力机制在NLP任务中被首次提出,用来对长时间(长距离)的关系进行建模。近期许多工作成功将注意力机制应用到语义分割、图像生成等计算机视觉任务中,用来提取长距离的关系。Wang等人[5]提出了非局部网络,利用自注意力机制摆脱了CNN局部感受野的限制,实现了对全图信息的聚合。受注意力机制启发,该工作将双目对极几何关系与注意力机制结合(如图1所示),提出了视差注意力机制。对于左图任意一个像元,视差注意力机制计算其与右图极线上所有像元的相似性,并聚焦到最相似的位置上,得到左右图的对应关系。

5.方法描述

5.1视差注意力机制

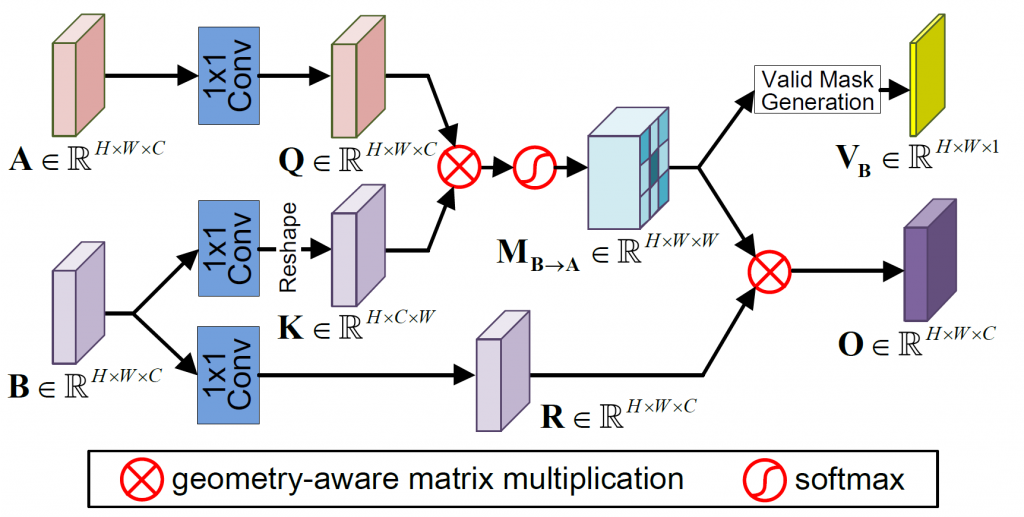

如图2所示,首先,利用 卷积对左右图提取的特征A,B∈![]() 进行处理,得到特征图Q,K,R∈

进行处理,得到特征图Q,K,R∈![]() ;其次,对K进行转置,将

;其次,对K进行转置,将![]() 与Q做矩阵乘,将结果通过softmax层得到视差注意力图

与Q做矩阵乘,将结果通过softmax层得到视差注意力图![]() ∈

∈![]() ;之后,将R与

;之后,将R与![]() 相乘,得到O∈

相乘,得到O∈![]() ,同时从

,同时从![]() 中得到有效掩膜

中得到有效掩膜![]() 。

。

视差注意力图描述了左右目图像极线方向上像元级的对应关系。基于视差注意力图,可以利用高效的矩阵乘操作实现左右目特征的转换。对于左右目图像(![]() )利用视差注意力图

)利用视差注意力图![]() ,可以得到左右目图像间的左右一致性与循环一致性:

,可以得到左右目图像间的左右一致性与循环一致性:

![]()

5.2基于视差注意力机制的无监督双目立体匹配

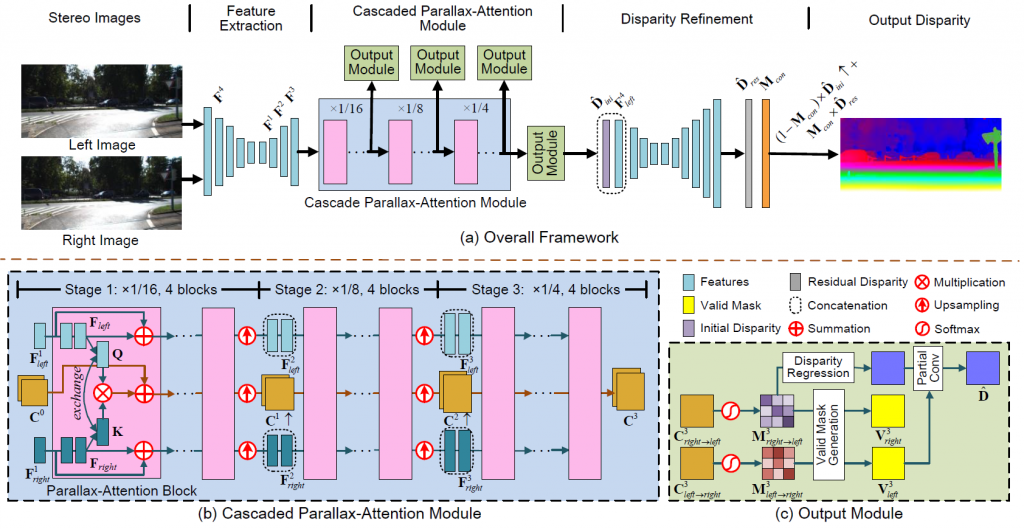

基于视差注意力机制的双目立体匹配网络结构如图3所示。对于输入的双目图像,首先利用沙漏模块进行多尺度特征提取;之后将提取的特征送入级联的视差注意力模块,得到视差注意力图;最后利用沙漏模块对视差注意力模块得到的视差图进行细化,得到最终的视差估计结果。

5.3基于视差注意力机制的双目图像超分辨

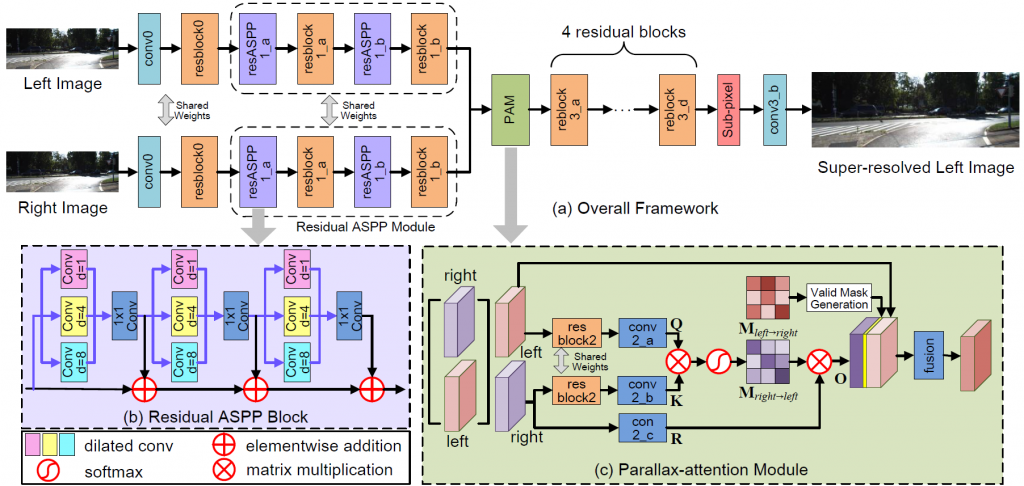

基于视差注意力机制的双目图像超分辨网络如图4所示。对于输入的双目低分辨率图像,首先利用一个卷积层和一个残差块提取浅层特征;其次将浅层特征送到残差空洞金字塔池化(ASPP)模块中进一步提取深层特征;之后利用视差注意力模块对左右目提取的特征进行聚合;最后,用4个残差块和上采样层对聚合特征进行重建和分辨率提升,得到最终的超分辨结果。

6.实验结果

6.1双目立体匹配

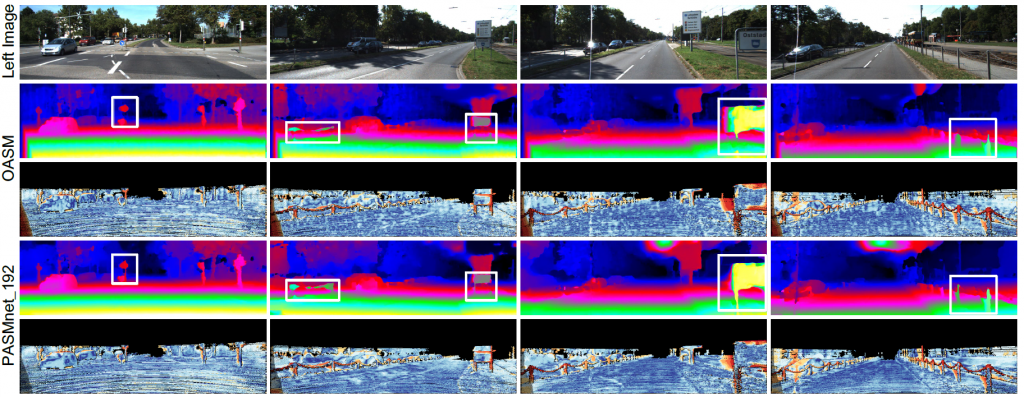

论文在KITTI 2015上开展了定量和定性实验。表1中的实验结果表明该方法取得了比已有无监督双目立体匹配方法更好的性能,缩小了与有监督方法的性能差距,图5中的可视化结果表明论文方法取得了更准确、更精细的视差估计结果。

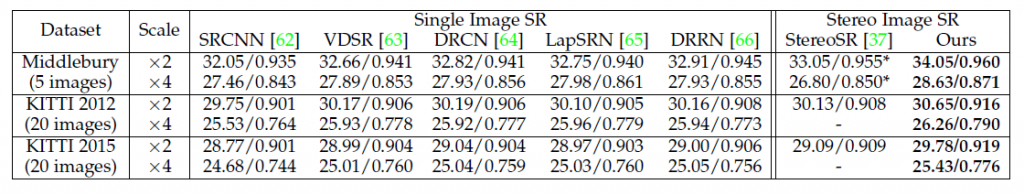

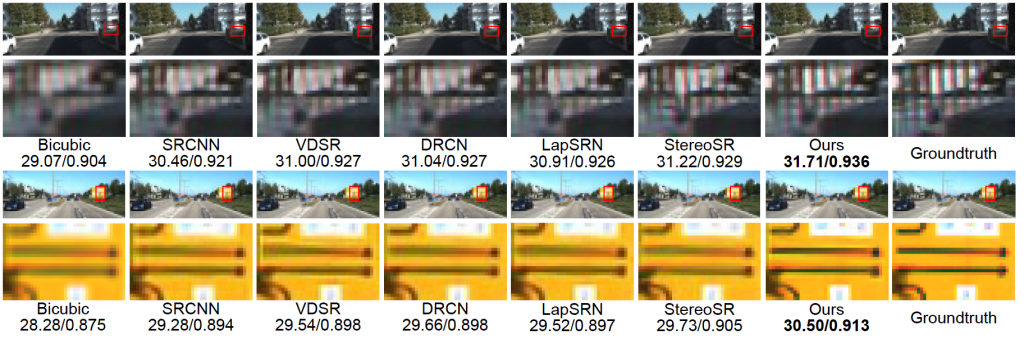

6.2双目图像超分辨

论文在Middlebury、KITTI 2012、KITTI 2015上开展了定量和定性实验。表2中的实验结果表明该方法取得了比单帧图像超分辨以及双目图像超分辨方法更好的性能,图6中的可视化结果表明论文方法取得了更好视觉效果,重建的细节更加清晰。

7.参考文献

[1] Nikolaus Mayer, et al. A large dataset to train convolutional networks for disparity, optical flow, and scene flow estimation. In CVPR, pages 4040–4048, 2016.

[2] Alex Kendall, et al. End-to-end learning of geometry and context for deep stereo regression. In ICCV, pages 66–75, 2017.

[3] Chao Zhou, Hong Zhang, Xiaoyong Shen, and Jiaya Jia. Unsupervised learning of stereo matching. In ICCV, pages 1576–1584, 2017.

[4] Daniel S. Jeon, et al. Enhancing the spatial resolution of stereo images using a parallax prior. In CVPR, pages 1721–1730, 2018.

[5] Xiaolong Wang, et al. Non-local neural networks. In CVPR, 2018.

成果速览主要聚焦于近年内在3DV领域的高质量原创研究(包括但不局限于论文、竞赛成果、应用展示、研究报告等),旨在为3DV领域的学者提供学术交流平台,增进对相互工作的了解。欢迎大家推荐或自荐优秀研究成果,如您有意成果展示,请与CSIG 3DV秘书处联系。

秘书处联系方式(郭裕兰:yulan.guo@nudt.edu.cn,武玉伟:wuyuwei@bit.edu.cn,杨佳琪: jqyang@nwpu.edu.cn)